Page 81 - 2022年第53卷第2期

P. 81

式中:Net 为求和函数;n 为输入单元的个数;I 为第 i 个输入历史气温变量; β 为一个偏重项; w ij

i

j

j

为连接权重。

激活函数用于计算神经元的输出,通过激活函数可以实现神经元的输入和输出之间非线性化。

本研究中全连接层上使用 Tanh 激活函数,也称为双正切函数:

z -z

f ( ) z = tanh( ) z = e - e -z (2)

j

z

e + e

相比于 Sigmiod、ReLU 等激活函数,Tanh 函数可以有效解决梯度弥散和无法携带负值信息的问

题,在特征相差明显时的效果会很好,在循环过程中会不断扩大特征效果。

因此,第 j 个神经元的输出,也即预测气温值为:

æ n ö

y = f çå( w ·I + β ÷ ) j (3)

i

ij

j

j

è i = 1 ø

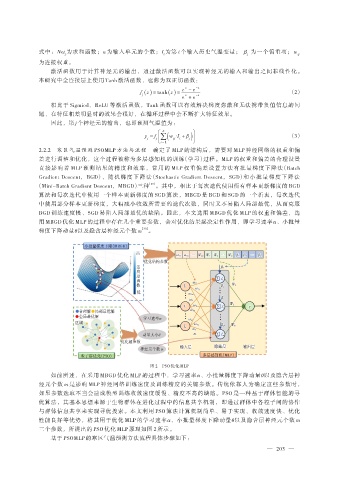

2.2.2 寒区气温预测 PSOMLP 方法与流程 确定了 MLP 的结构后,需要对 MLP 神经网络的权重和偏

差进行调整和优化,这个过程被称为多层感知机的训练(学习)过程。MLP 的权重和偏差的合理设置

直接影响着 MLP 预测结果的精度和效率,常用的 MLP 权重偏差设置方法有批量梯度下降法(Batch

Gradient Descent, BGD)、 随 机 梯 度 下 降 法(Stochastic Gradient Descent, SGD)和 小 批 量 梯 度 下 降 法

(Mini-Batch Gradient Descent,MBGD)三种 [29] 。其中,相比于每次迭代使用所有样本更新梯度的 BGD

算法和每次迭代中使用一个样本更新梯度的 SGD 算法,MBGD 是 BGD 和 SGD 的一个折衷,每次迭代

中使用部分样本更新梯度,大幅减小收敛所需要的迭代次数,同时又不易陷入局部最优,从而克服

BGD 训练速度慢、SGD 易陷入局部最优的缺陷。因此,本文选用 MBGD 优化 MLP 的权重和偏差,选

用 MBGD 优化 MLP 的过程中存在几个重要参数,会对优化结果起决定性作用,即学习速率α、小批量

梯度下降动量θ以及隐含层神经元个数 m [30] 。

小批量梯度下降(MBGD)

高 ω ω 1111 ω 1212 … W W nmnm W 1 W 2 … W W m β 1 1 β β 2 … β β m m

β

W

W

ω

…

…

…

1

m

2

2

度 函 适 应 数 优化结构参数

β β 1 1

å| f 1

ω ω 1111

W W 1 1

β β j j

I I 1 1

ω ω 1j 1 j

低

ω ω 1m 1 m

β β j j

ω ω i1 i 1

W W 2 2

ω ω ijij y y

I I i i å| f j

合理解 局部最优解 ω ω imim

全局最优解 学习速率α

区域 ω ω n1 n 1

ω ω njnj

β β m m W W m m

I I n n

ω ω n n

动量大小θ m m å| f m

优化超参数

藏

层

隐

层

出

输

入

层

输

神经元个数 m 输入层 隐藏层 输出层

粒子群优化(PSO) 多层感知机(MLP)

图 2 PSO 优化 MLP

如前所述,在采用 MBGD 优化 MLP 的过程中,学习速率α、小批量梯度下降动量θ以及隐含层神

经元个数 m 是影响 MLP 神经网络训练速度及训练精度的关键参数。传统依靠人为确定这些参数时,

如果参数选取不当会造成模型训练收敛速度缓慢、精度不高的缺陷。PSO 是一种基于群体智能的寻

优算法,其基本思想来源于生物群体在进化过程中的信息共享机制,即通过群体中各粒子间的协作

与群体信息共享来实现寻优搜索。本文利用 PSO 算法计算机制简单、易于实现、收敛速度快、优化

性能良好等优势,将其用于优化 MLP 的学习速率α、小批量梯度下降动量θ以及隐含层神经元个数 m

三个参数,所提出的 PSO 优化 MLP 原理如图 2 所示。

基于 PSOMLP 的寒区气温预测方法流程具体步骤如下:

— 203 —