Page 32 - 2024年第55卷第1期

P. 32

计、进度分析等工作。实际施工日志影像通常具有如下特点:

( 1)图像畸变。纸质施工日志在打印和影像化过程中出现倾斜、旋转、扭曲的情况。

( 2)手绘线段与表格模板相似。施工日志的记录使用的签字笔笔迹与印刷的表格模板相近。

( 3)手绘线段不平直。手绘线段难以保证绘制的线段平直顺滑。

( 4)手绘线段旁会有文字记录。手绘横道图旁通常有施工参数、突发事件处理过程等文字记录。

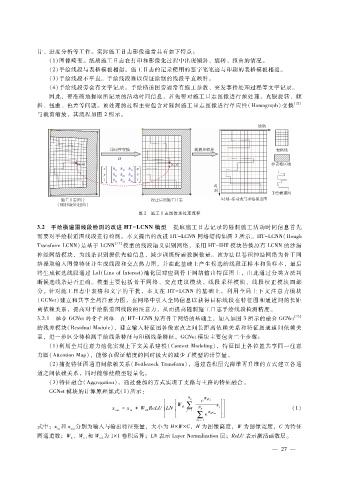

因此,要准确地提取所记录的活动时间信息,首先要对施工日志图像进行预处理,克服旋转、倾

斜、扭曲、色差等问题。预处理的过程主要包含对隧洞施工日志图像进行单应性(Homograph)变换 [22]

与裁剪缩放,其流程如图 2所示。

图 2 施工日志图像预处理流程

3.2 手绘横道图线段检测的改进 HT - LCNN模型 提取施工日志记录的隧洞施工活动时间信息首先

需要对手绘横道图线段进行检测。本文提出的改进 HT - LCNN网络结构如图 3所示。HT - LCNN(Hough

Transform LCNN)是基于 LCNN [17] 模型的线段语义识别网络,采用 HT - IHT模块替换原有 LCNN的沙漏

神经网络模块,为线条识别提供先验信息,减少训练所需数据数量。该方法以卷积神经网络为骨干网

络提取输入图像特征并生成线段和交点热力图,并在此基础上产生候选的线段正样本和负样本,最后

将生成候选线段通过 LoI(LineofInterest)池化层对应到骨干网络输出特征图上,由此通过分类方法判

断候选线条是否正确。模型主要包括骨干网络、交点建议模块、线段采样模块、线段校正模块四部

分。针对施工日志中表格和文字的干扰,本文在 HT - LCNN的基础上,利用全局上下文注意力模块

( GCNet)建立和共享全局注意力图,在网络中引入全局信息以获得目标线段在特征图和通道间的长距

离依赖关系,提高对手绘横道图线段的注意力,从而提高隧洞施工日志手绘线段检测精度。

[23]

3.2.1 融合 GCNet的骨干网络 在 HT - LCNN原有骨干网络的基础上,加入如图 3所示的融合 GCNet

的残差模块(ResidualModule),建立输入特征图各像素点之间长距离依赖关系和特征图通道间依赖关

系,进一步区分待检测手绘线条特征与印刷线条特征。GCNet模块主要包含三个步骤:

( 1)利用全局注意力池化实现上下文关系建模(ContextModeling),特征图上各位置共享同一注意

力图( AttentionMap),能够在保证精度的同时极大的减少了模型的计算量。

( 2)捕捉特征图通道间依赖关系(BottleneckTransform),通过卷积层先降维再升维的方式建立各通

道之间依赖关系,同时能够使模型轻量化。

( 3)特征融合(Aggregation),通过叠加的方式实现了支路与主路的特征融合。

GCNet模块的计算原理如式(1)所示:

N p W k x j

e

W v1∑ x

x =x +W ReLU LN N p j (1)

out in v2 j =1 W k x m

∑ e

m=1

式中:x和 x 分别为输入与输出特征张量,大小为 H × W× C,H为图像高度,W为图像宽度,C为特征

out

in

图通道数;W 、W 和 W 为 1 × 1卷积运算;LN表示 LayerNormalization层;ReLU表示激活函数层。

k v1 v2

— 2 7 —