Page 85 - 2024年第55卷第11期

P. 85

3

电耗水量,目标流量 Q 取最小下泄流量 327m ?s;汛期优化目标设置为控制电站上游水位,即最小

target

化上游水位与目标水位的偏差,为保证电站防洪安全并减少弃水,目标水位 Z 取 622m,目标流量

target

Q target 由式(4)计算。为从多维度探究模型的优化性能,本文采用负荷分配表作为 DQN算法的对比方

法,并以 2种负荷分配方式与是否考虑预报信息为基础,设置 4种对比方案,如表 2所示。由于负荷

分配表包含电站在各水头、各负荷指令下所有满足约束的负荷分配方式,因此分配表的大小与选取的

离散精度密切相关,在综合考虑计算时间与计算效率后,选取负荷离散精度 3MW,水头离散精度 0.1m

的负荷分配表。

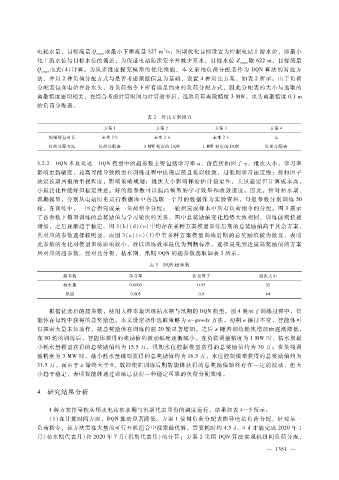

表 2 对比方案设置

方案 1 方案 2 方案 3 方案 4

预报信息时长 未来 2h 未来 2h 未来 2h 无

负荷分配方法 负荷分配表 3MW 精度的 DQN 1MW 精度的 DQN 负荷分配表

3.2.2 DQN参数优选 DQN模型中的超参数主要包括学习率 α ,价值折扣因子 γ ,批次大小。学习率

影响更新幅度,过高可能导致模型在训练过程中出现震荡且难以收敛,过低则学习速度慢;折扣因子

决定长期回报的重视程度,影响策略规划;批次大小影响梯度估计稳定性,大虽稳定但计算成本高,

小虽泛化性能好但稳定性差。好的超参数可以提高模型的学习效果和收敛速度。因此,针对枯水期、

汛期模型,分别从电站历史运行数据库中各选取一个月的数据作为实验资料,每组参数分别训练 50

轮。在训练中,一回合指完成某一负荷指令分配;一轮指完成样本中所有负荷指令的分配。图 3展示

了各参数下模型训练的总奖励值与学习轮次的关系,图中总奖励值变化趋势大致相同,训练前期快速

增加,之后逐渐趋于稳定。图 3(b)(d)(e)中均存在某种方案模型训练后期的总奖励值高于其余方案,

其对应的参数选择较明显。而图 3(a)(c)(f)中有多种方案模型训练后期的总奖励值较为接近,表明

此参数的变化对模型训练影响较小,故以训练效率最优为判断标准,选择最先到达最高奖励值的方案

所对应的超参数。经对比分析,枯水期、汛期 DQN的超参数选取如表 3所示。

表 3 DQN超参数

超参数 学习率 折扣因子 批次大小

枯水期 0.0005 0.95 32

汛期 0.005 0.8 64

根据优选后的超参数,使用大样本集训练枯水期与汛期的 DQN模型。图 4展示了训练过程中,智

能体在每轮中获得的总奖励值。本文设定动作选取策略为 ε - greedy 方法,初期 ε 保持不变,智能体可

以探索大量未知动作,故总奖励值在训练的前 20轮显著增加。之后 ε随着训练轮次增加而逐渐降低,

在 80轮的训练后,智能体获得的奖励值的波动幅度逐渐减小。在负荷调整精度为 1MW 时,枯水期最

小耗水量模型获得的总奖励值约为 15.5万,汛期水位控制模型获得的总奖励值约为 30万;在负荷调

整精度为 3MW 时,最小耗水量模型获得的总奖励值约为 16.5万,水位控制模型获得的总奖励值约为

31.5万。而由于 ε 始终大于 0,故即使在训练后期智能体获得的总奖励值始终存在一定的波动,但大

小趋于稳定,表明智能体通过训练已获得一种稳定可靠的负荷分配策略。

4 研究结果分析

4种方案指导枕头坝水电站枯水期与汛期代表月份的调度运行,结果如表 4—5所示:

( 1)在计算时间方面,DQN算法显著降低。方案 1使用负荷分配表指导电站负荷分配,针对某一

负荷指令,该方法需在大量的可行开机组合中搜索最优解,需要耗时约 4.5d、4d才能完成 2020年 1

月(枯水期代表月)和 2020年 7月(汛期代表月)的计算;方案 2采用 DQN算法实现机组间负荷分配,

3

— 1 5 1 —