Page 126 - 2024年第55卷第8期

P. 126

式中:t和 t - 1分别为当前时刻和前一时刻;h和 h 分别为当前时刻和前一时刻的隐藏层状态;C和

t t - 1 t

C 代表当前时刻和前一时刻的记忆状态单元;W 、W 、W 和 W 分别为遗忘门、输入门、记忆状态

t - 1 f i c o

单元和输出门的权值;b、b、b和 b分别为遗忘门、输入门、记忆状态单元和输出门的偏置;x为当

i

f

c

t

f

C

前时刻的输入值; 珟 为候选状态单元;σ (x)为 Sigmoid激活函数。

t

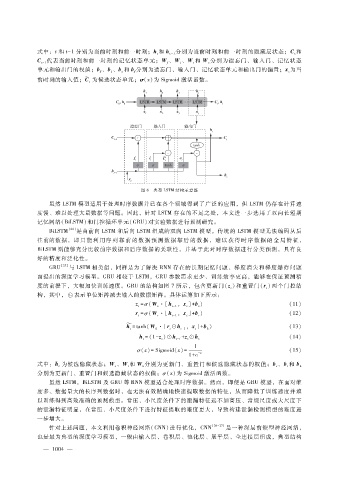

图 6 典型 LSTM结构示意图

虽然 LSTM模型适用于处理时序数据并已在各个领域得到了广泛的应用,但 LSTM 仍存在计算速

度慢、难以处理大量数据等问题。因此,针对 LSTM存在的不足之处,本文进一步选用了双向长短期

记忆网络(BiLSTM)和门控循环单元(GRU)对实验数据进行预测研究。

BiLSTM [24] 是由前向 LSTM和后向 LSTM组成的双向 LSTM模型。传统的 LSTM 模型无法编码从后

往前的数据,即 只 能 利 用 序 列 靠 前 的 数 据 预 测 数 据 靠 后 的 数 据,难 以 获 得 时 序 数 据 的 全 局 特 征,

BiLSTM则能够充分比较前序数据和后序数据的关联性,并基于此对时序数据进行分类预测,具有良

好的精度和泛化性。

GRU [25] 与 LSTM相类似,同样是为了解决 RNN存在的长期记忆问题、梯度消失和梯度爆炸问题

而提出的深度学习模型。GRU相较于 LSTM,GRU参数需求更少、训练效率更高,能够在保证预测精

度的前提下,大幅加快训练速度。GRU的结构如图 7所示,包含更新门(z)和重置门(r)两个门控结

t

t

构,其中, 表示单位矩阵减去输入的数据矩阵。具体运算如下所示:

z = σ (W ·[h ,x] + b) (11)

t - 1

z

t

z

t

r = σ (W ·[h ,x] + b) (12)

t r t - 1 t r

槇 (13)

h= tanh (W ·[r ⊙h ,x] + b)

t h t t - 1 t h

珘

h= (1 - z) ⊙h + z ⊙h t (14)

t

t

t

t - 1

1

σ (x) =Sigmoid (x) = (15)

- x

1 + e

h

式中: 珘 为候选隐藏状态;W 、W 和 W 分别为更新门、重置门和候选隐藏状态的权值;b、b和 b

t z r h z r h

分别为更新门、重置门和候选隐藏状态的权值;σ (x)为 Sigmoid激活函数。

虽然 LSTM,BiLSTM及 GRU等 RNN模型适合处理时序数据。然而,即便是 GRU模型,在面对维

度多、数据量大的长序列数据时,也无法有效精确地快速提取数据的特征,从而降低了训练速度并难

以训练得到高效准确的预测模型。常压、小尺度条件下的泄漏特征远不如高压、常规尺度或大尺度下

的泄漏特征明显,在常压、小尺度条件下进行特征提取的难度更大,导致构建泄漏检测模型的难度进

一步增大。

针对上述问题,本文利用卷积神经网络( CNN)进行优化,CNN [26 - 27] 是一种深层前馈型神经网络,

也是最为典型的深度学习模型,一般由输入层、卷积层、池化层、展平层、全连接层组成,典型结构

— 1 0 4 —

0