Page 127 - 2024年第55卷第8期

P. 127

图 7 典型 GRU结构示意

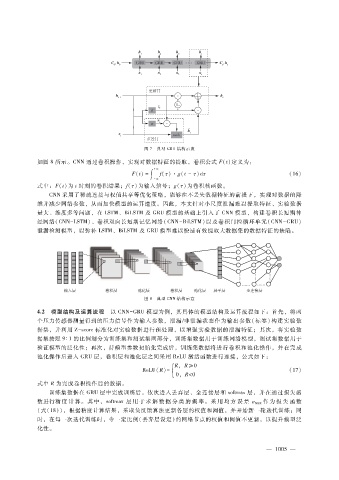

如图 8所示。CNN通过卷积操作,实现对数据特征的提取,卷积公式 F(t)定义为:

+ ∞

F(t) = ∫ f( τ )·g(t -τ )d τ (16)

- ∞

式中:F(t)为 t时刻的卷积结果;f( τ )为输入信号;g( τ )为卷积核函数。

CNN采用了稀疏连接与权值共享等优化策略,能够在不丢失数据特征的前提下,实现对数据的降

维并减少网络参数,从而加快模型的运算速度。因此,本文针对小尺度泄漏难以提取特征、实验数据

量大、维度多等问题,在 LSTM、BiLSTM及 GRU模型的基础上引入了 CNN模型,构建卷积长短期神

经网络( CNN - LSTM)、卷积双向长短期记忆网络(CNN - BiLSTM)以及卷积门控循环单元(CNN - GRU)

泄漏检测模型,以弥补 LSTM、BiLSTM及 GRU模型难以快速有效提取大数据集的数据特征的缺陷。

图 8 典型 CNN结构示意

4.2 模型结构及运算流程 以 CNN - GRU模型为例,其具体的模型结构及运算流程如下:首先,将两

个压力传感器测量得到的压力信号作为输入参数,泄漏?非泄漏状态作为输出参数(标签)构建实验数

据集,并利用 Z - score标准化对实验数据进行预处理,以增强实验数据的泄漏特征;其次,将实验数

据集按照 9∶1的比例划分为训练集和测试集两部分,训练集数据用于训练网络模型,测试集数据用于

验证模型的泛化性;再次,待模型参数初始化完成后,训练集数据将进行卷积和池化操作,并在完成

池化操作后进入 GRU层,卷积层和池化层之间采用 ReLU激活函数进行连接,公式如下:

ReLU(R) = { R,R ≥0 (17)

0,R<0

式中 R为完成卷积操作后的数据。

训练集数据在 GRU层中完成训练后,依次进入丢弃层、全连接层和 softmax层,并在通过损失函

作 为 损 失 函 数

数进行精 度 计 算。其 中,softmax层 用 于 求 解 数 据 分 类 的 概 率。 采 用 均 方 误 差 ε MSE

(式(18)),根据精度计算结果,采取负反馈算法更新各层的权值和阈值,并开始新一轮迭代训练;同

时,在每一次迭代训练时,令一定比例(丢弃层设定)的网络节点的权值和阈值不更新,以提升模型泛

化性。

0

— 1 0 5 —