Page 65 - 2025年第56卷第9期

P. 65

近年来,大语言模型的发展为水库调度规则文本的标准化处理提供了一个新的途径 [18-20] 。大语言

模型是基于深度学习技术,在海量的语料库上进行预训练的大规模神经网络模型,如 ChatGPT、BERT

和 LLaMA 等代表性模型的发展 [21-22] ,使其在自然语言处理领域展现出卓越的能力,不仅能够捕获语言

的语法和语义特性,还能在上下文理解、语义解析、语言生成等任务中表现出接近人类的水平。因

此,大语言模型以其强大的自然语言处理能力,可以自动识别调度规则中的关键语义信息,并生成统

一、逻辑清晰的描述,从而提高规则表达的标准化和一致性,使其成为将调度规则文本转化为标准化

结构的理想工具。

但是,目前使用最广、能力最强的大语言模型工具,如 ChatGPT、文心一言等,均为在线大语言

模型,其依赖于集中式的云服务,用户的数据在传输、存储和处理过程中存在泄露或被滥用的风

险 [23-25] 。从隐私保护的角度看,水库调度规则通常涉及敏感数据和关键基础设施信息,要求数据处理

在本地完成,避免潜在的信息泄露风险。因此,大语言模型的本地化部署不仅能够满足隐私和安全要

求,还能适应水库群调度中的低带宽或无网络环境,提升调度系统的鲁棒性和可靠性。基于此,本研

究 采 用 Windows PowerShell 和 Ollama 平 台 以 及 千 问 大 语 言 模 型(Qian wen large language model,

QwenLLM),实现大语言模型的本地化部署,从而对调度规则文本进行本地化处理。

3.1.2 大语言模型本地化部署及 DT 调度规则构建 QwenLLM 是由阿里巴巴集团开发的一种大语言模

型,其在自然语言处理领域展现出了卓越的性能,特别是针对中文语言特点进行了深度优化,能够

准确理解复杂的中文语法结构及含义 [26] 。QwenLLM 集成了最新的自然语言处理技术,采用了多层自

注意力机制来捕捉长距离依赖关系,增强了模型对复杂语言结构的理解能力,能够灵活应用于从日

常对话系统到专业领域知识问答的多种场景。从模型效果对比结果来看,QwenLLM 在某些关键指标

[27]

上已经超越了 ChatGPT 3.5 。本研究基于 Windows PowerShell 和 Ollama 实现对 QwenLLM 的本地化部

署,主要流程包括:硬件与软件环境准备、模型选择与部署以及验证与实例应用等,主要流程如

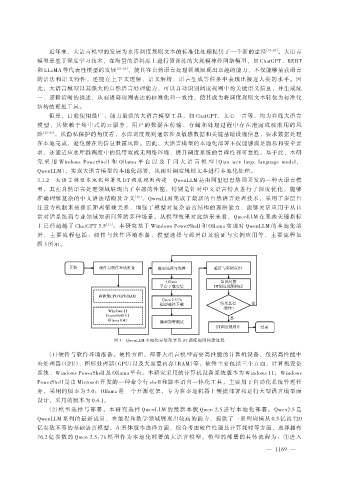

图 3 所示。

图 3 QwenLLM 本地化安装部署及 DT 调度规则构建流程

(1)硬件与软件环境准备。硬件方面,部署大语言模型需要高性能的计算机设备,包括高性能中

央处理器(CPU)、图形处理器(GPU)以及大容量内存(RAM)等。软件主要包括三个方面,计算机设备

系统、Windows PowerShell 及 Ollama 平台。本研究采用的计算机设备系统版本为 Windows 11;Windows

PowerShell 是由 Microsoft 开发的一种命令行 shell 和脚本语言一体化工具,主要用于自动化系统管理任

务,采用的版本为 5.0;Ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型而

设计,采用的版本为 0.4.1。

(2)模型选择与部署。本研究选择 QwenLLM 的最新本版 Qwen 2.5 进行本地化部署。Qwen2.5 是

QwenLLM 系列的最新成员,在编程和数学领域展现出较高的能力,提供了一系列规模从 0.5 亿到 720

亿参数不等的基础语言模型。在具体版本选择方面,综合考虑硬件性能及计算耗时等方面,选择拥有

76.2 亿参数的 Qwen 2.5:7b 模型作为本地化部署的大语言模型。模型的部署的具体流程为:①进入

— 1169 —