Page 92 - 2024年第55卷第8期

P. 92

通过调整 TF层的时间窗长度 L,可将地震记录序列的时间步长度缩小到适合 Encoder输入的长

度。一般 STFT中的时间窗平移距离设为 L?2,此时经过 TF层时频变换后的时频信息在时域和频域上

2 T L

的维度分别为 N = + 1 和 N = + 1 。同时在 Decoder的全连接层后接入 ITF层,并设置与 TF对应的

1 2

L 2

时间窗和窗参数,将虚拟传感器输出的虚拟地震信号的时频信息逆变换回地震信号时间序列。其中,

时频逆变换方法采用与 STFT对应的短时傅里叶逆变换(InverseShort - TimeFourierTransform,ISTFT)方

法,其计算公式如下:

1

槇

ISTFT(t,f) = ∫ i2 π f τ (9)

Y( τ )h(x-t)e d τ

2 π

槇

式中 Y(t)为虚拟传感器输出的虚拟地震信号的时频信息。

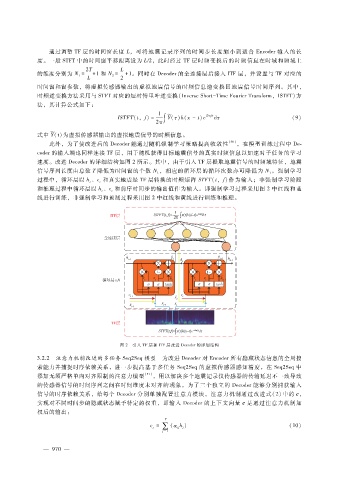

此外,为了使改进后的 Decoder能通过随机强制学习策略提高收敛性 [30] ,在模型训练过程中 De

coder的输入端也同样连接 TF层,用于随机获得目标地震信号的真实时频信息以加速对子任务的学习

速度。改进 Decoder的详细结构如图 2所示。其中,由于引入 TF层提取地震信号的时频域特征,地震

信号序列长度由总数 T降低为时间窗的个数 N,相应的循环层的循环次数亦可降低为 N。强制学习

1 1

过程中,循环层以 h、c和真实地震经 TF层转换的时频矩阵 STFT(t,f)作为输入;非强制学习阶段

t t

和推理过程中循环层以 h、c和前序时间步的输出值作为输入。即强制学习过程采用图 2中红线和蓝

t

t

线进行训练,非强制学习和预测过程采用图 2中红线和黄线进行训练和推理。

图 2 引入 TF层和 ITF层改进 Decoder的详细结构

3.2.2 注意力机制改进的多任务 Seq2Seq模型 为改进 Decoder对 Encoder所有隐藏状态信息的全局搜

索能力并捕捉时序依赖关系,进一步提高基于多任务 Seq2Seq的虚拟传感器感知精度,在 Seq2Seq中

添加无须严格单向对齐限制的注意力模型 [31] ,用以解决多个地震记录仪传感器的传输延迟不一致导致

的传感器信号的时间序列之间在时间维度未对齐的现象。为了三个独立的 Decoder能够分别捕获输入

信号的时序依赖关系,给每个 Decoder分别单独配置注意力模块。注意力机制通过改进式(2)中的 c,

实现对不同时间步的隐藏状态赋予特定的权重,即输入 Decoder的上下文向量 c是通过注意力机制加

权后的输出:

T

t ∑

c= ( α ij j (10)

h)

j =1

0

— 9 7 —