Page 44 - 2024年第55卷第9期

P. 44

最佳处理效果。从以上步骤可看出本文所提方法自适应较强,主要体现在三个方面:(1)CEEMDAN

算法自身已具备自适应性质。在分解过程中,自适应先前分解所得各分量数据特征,动态完成下阶分

量的计算,而非依靠某一固定公式完成所有计算,各分量之间并非相互 割 裂,而是 存在 递进关系。

(2)在阈值降噪过程中针对每一个分量单独设置阈值及函数,针对序列长度、第一阶分量的绝对变差

中值及各分量相应阶次进行综合考虑,依据数据特性进行动态调整。( 3)利用 GWO对参数组合进行最

佳寻优,将其与 CEEMDAN及阈值降噪法相结合,依据包含噪声的实际时序数据特性进行自适应动态

组合寻优,而非不加判别针对任何数据序列均采用通用参数,从而自适应完成降噪。

2.2 递归特征选择 作为寻找最优特征集合的 RFECV是一种包裹式特征选取 “贪心” 算法,通过反

复建立多种模型,借助可以赋予特征权重的 coef_属性或 feature_importances_属性进行特征重要程度评

价 [23] 。然后,经过修剪移除设定数量下相应的最不重要特征,在更新后的特征集合中递归重复该步

骤,对特征变量不断筛选直至遍历所有特征,最终得到所需特征数量相应的最优特征集合。

由于无法提前准确判断有效特征的个数,该方法虽然可以保留指定数量的特征集合,但有效信息

可能存在于被移除的特征中,导致模型在修剪后的数据集上所表现出的性能并非最优,这与方差过滤

法、单变量特征法类似,可能受到人为选择特征数量的主观影响;同时计算结果的稳定性与所选元学

习器具有相关性。因此本文将结合多种元学习器对所有可能的特征数量及相应特征集合进行遍历,基

于 k折交叉试验所得评价指标的均值来选取最优学习器与最优特征集合。该算法基本实现步骤如下:

步骤 1:以原始数据集为初始特征集并确定需要保留的特征数量;

步骤 2:选取学习器并使用当前特征集进行建模,计算每个特征的重要性;

步骤 3:进行特征迭代,删除最不重要的 X个(一般为 1)特征,更新当前特征集;

步骤 4:反复进行步骤 2与步骤 3,直到获得指定数量下的最优特征集合,终止迭代;

步骤 5:进行 k折交叉试验,对比各指定特征数量下所得评价指标的均值,选取最优学习器与最

优特征集合。

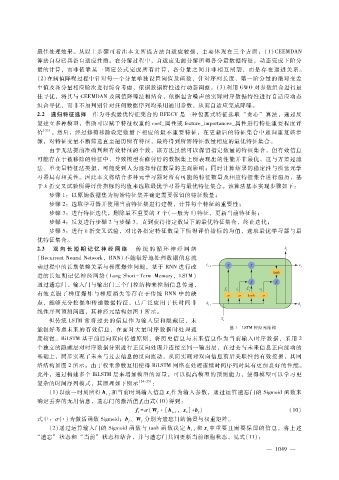

2.3 双 向 长 短 期 记 忆 神 经 网 络 传 统 的 循 环 神 经 网 络

(RecurrentNeuralNetwork,RNN)不能很好地处理数据信息流

动过程中的长期依赖关系与梯度爆炸问题,基于 RNN进行改

进的长短期记忆神经网络(LongShort - Term Memory,LSTM)

通过遗忘门、输入门与输出门三个门控结构来控制信息传递,

有效克服了梯度爆炸与梯度消失等存在于传统 RNN中的 缺

点,能够充分挖掘和传递数据特征,已广泛应用于长时间非

线性序列预测问题,其神经元结构如图 1所示。

但传统 LSTM 常将过去的信息作为输入层和隐藏层,未

能很好考虑未来的有效信息,在面对大量时序数据时处理速 图 1 LSTM神经元结构

度较慢。BiLSTM基于前后向双向传播原则,将历史信息与未来信息作为当前输入时序数据,采用 2

个独立的隐藏层对时序数据分别进行正反向处理并连接至同一输出层,在过去与未来信息正向流动的

基础上,同步实现了未来与过去信息的反向流动,从而实现对双向信息前后关联性的有效挖掘,其网

络结构如图 2所示。由于权重参数复用使得 BiLSTM网络在处理连续时间序列时具有更加良好的性能。

此外,通过构建多个 BiLSTM层来增加模型的容量,可以提高模型的预测能力,使得模型可以学习更

复杂的时间序列模式,其原理如下所示 [24 - 25] :

(1)以前一时刻所得 h 和当前时刻输入信息 x作为输入参数,通过运算遗忘门的 Sigmoid函数来

t - 1

t

确定丢弃的无用信息,遗忘门的激活值 f由式(10)得到:

t

f = σ (W ·[h ,x] + b) (10)

f

f

t

t

t - 1

式中:σ (·)为激活函数 Sigmoid;b、W 分别为遗忘门的偏置与权重矩阵。

f

f

( 2)通过运算输入门的 Sigmoid函数与 tanh函数决定 h 和 x中重要且需要保留的信息,将上述

t - 1 t

“遗忘” 状态和 “当前” 状态相结合,并与遗忘门共同更新当前细胞状态,见式(11):

0

— 1 4 9 —