Page 65 - 2022年第53卷第12期

P. 65

方法与机器学习模型来建立分解集成模型可有效改进单一机器学习模型的预测精度 [7 - 9] 。其中,VMD

方法能够控制中心频率混叠现象和噪声水平,更易于提高分解集成模型的预测性能 [10 - 12] 。

建立分解集成模型来提高径流预测精度已成为当前研究热点之一 [13 - 15] 。但是,这类模型首先将整

个径流序列分解成若干个子序列,再将这些子序列划分为训练期和验证期,这种先分解后划分法会导

致研究者在训练模型之前,提前使用了验证期数据,难以满足实际预报需求 [16] 。对于单变量分解集成

模型,模型是将当期预测径流和前期径流作为预测模型的下一步预报因子,显然在验证模型的预测性

能时,当预测径流需要依靠预测模型预测。若将上述先分解后划分法用于构建单变量分解集成模型,

会导致验证期内的预报因子数据被视为已知数据处理。Du等 [17] 和 Fang等 [18] 对比分析了多种分解集

成水文预测模型的结果,发现将验证期内预报因子数据当作已知数据去构建分解集成模型会得到 “虚

假” 的高精度预测结果。分解集成模型的正确构建过程需先将实测序列划分为训练期和验证期,再将

训练期数据进行分解建模,但其预测精度相对降低 [19] 。为此,Fang等 [18] 提出一种逐步分解采样技术

来构建正确的分解集成模型,以期提高正确分解集成模型的预测精度。该逐步分解采样技术可作为分

解集成模型的替代采样技术,但使用该技术构建的分解集成模型的预测精度依旧较低。因此,如何正

确构建能应用于现实径流预报工作中的较高精度分解集成径流预测模型尚需深入研究。

上述研究均旨在提高和改进模型的点预测性能,但点预测结果仅为一个确定数值,难以描述由于

径流序列随机性和波动性而导致的预测不确定性。把握未来径流数据的波动范围和预测的不确定性,

有助于研究者做出更加科学合理的分析、评估和决策。区间预测可通过参数或非参数密度估计方法估

计点预测误差的分布特性,进而构建一定置信水平下的预测区间,可在一定程度上体现预测的不确定

性。与参数估计模型相比,非参数核密度估计( Kerneldensityestimation,KDE)方法不需提前假设误差

样本服从的分布函数,避免因误差分布选取错误导致出现较大预测误差问题 [20] 。KDE方法已广泛应

用于区间预测研究中,例如,Li等 [21] 提出了基于分数阶灰色模型与 KDE方法的混合模型,并将该模

型用于农业用水量预测,Guo等 [22] 构建了基于自激励自回归模型与 KDE方法的地下水埋深区间预测

模型,王晓东等 [23] 将分位数回归、长短记忆神经网络与 KDE方法进行结合,构建了风电功率概率预测

模型。这些研究结果均表明,KDE方法可通过结合适宜的点预测模型产生较高精度的区间预测结果。

本文提出一种可同时进行点预测和区间预测的 VMD - SVM- KDE逐步分解集成模型,并提出两阶

段粒子群优化( TSCPSO)算法来优化模型参数。该模型可解决现有分解集成预测模型错误使用验证期

内预报因子数据的问题,并能提高分解集成模型的预测精度。VMD - SVM- KDE - TSCPSO模型可有效解

决传统分解集成模型被错误开发和预测精度较低的问题,拓展该类模型在实际预报业务中的可应用性。

2 方法

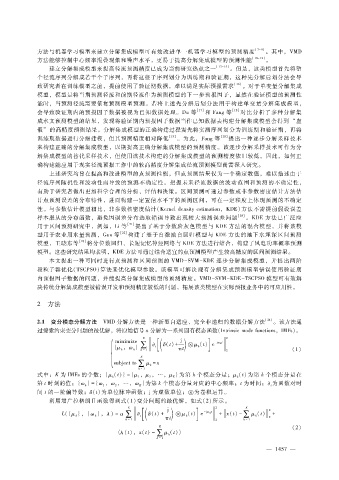

2.1 变分模态分解方法 VMD分解方法是一种新型自适应、完全非递归的数据分解方法 [24] 。该方法通

过搜索约束变分问题的最优解,将原始信号 x分解为一系列固有模态函数(Intrinsicmodefunctions,IMFs)。

K 2

]

( [

minimize t δ (t) + j ) (t) e

- j ω k t

} ∑ μ k

{ μ k ,ω k π t (1)

k =1 2

K

subjectto ∑ μ k = x

k =1

(t)为第 k个模态分量在

式中:K为 IMFs的个数;{ μ k (t)} = { μ 1 ,μ 2 ,…,μ K }为第 k个模态分量;μ k

为函数对时

第 t时刻的值;{ ω k } = { ω 1 ,ω 2 ,…,ω K }为第 k个模态分量对应的中心频率;t为时间; t

间 t的一阶偏导数;δ (t)为单位脉冲函数;j为虚数单位;为卷积运算。

利用增广拉格朗日函数得到式( 1)变分问题的最优解,如式(2)所示。

K j 2 K 2

]

( [

},λ ) =α t δ (t) + ) (t) e - j ω k t + x (t) - (t) +

L({ μ k },{ ω k ∑ μ k ∑ μ k 2

k =1 π t 2 k =1

K (2)

〈 λ (t),x(t) - ∑ μ k (t)〉

k =1

4

— 1 5 7 —