Page 26 - 2023年第54卷第2期

P. 26

{ ε (t - 1)?s, ε >10 - 6

2

ε (t) = (6)

0, ε≤10 - 6

式中:s、s为收缩系数,取值 1.035;一般情形下,ε (0)和 δ (0)通常取为 1。

1

2

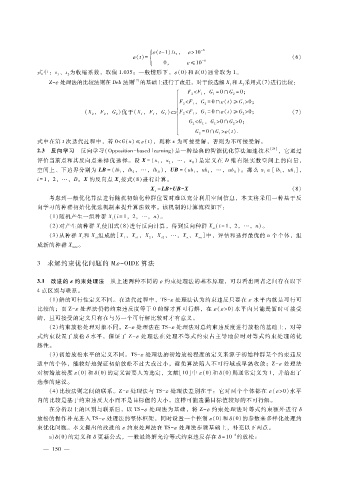

Z - ε 处理法的比较法则在 Deb法则 [7] 的基础上进行了改进,对于候选解 X和 X采用式(7)进行比较:

1 2

F<F,G = 0 ∩G = 0;

1

2

1

2

F<F,G = 0 ∩ε (t) ≥G>0;

2 1 2 1

( X,F,G)优于(X,F,G) F<F,G = 0 ∩ε (t) ≥G>0; (7)

2 2 2 1 1 1 2 1 1 2

G<G,G>0 ∩G>0;

2

1

2

1

G = 0 ∩G> ε (t).

2 1

式中在第 t次迭代过程中,若 0<G(x) ≤ε (t),则称 x为可接受解,否则为不可接受解。

2.3 反向学习 反向学习(Opposition - basedlearning)是一种经典的智能优化算法加速技术 [24] ,它通过

评价当前点和其反向点来择优选择。设 X= (x,x,…,x)是定义在 D维有限实数空间上的向量,

1 2 D

空间上、下边界分别为 LB= (lb,lb,…,lb),UB= (ub,ub,…,ub)。那么 x∈ [lb,ub],

i

i

i

1

2

D

1

2

D

i = 1,2,…,D。X的反向点 X按式(8)进行计算。

o

X = LB + UB - X (8)

o

考虑到一般优化算法进行随机初始化种群位置时难以充分利用空间信息,本文将采用一种基于反

向学习的种群初始化优选机制来提升算法效率。该机制的计算流程如下:

( 1)随机产生一组种群 X(i = 1 ,2,…,n)。

i

(2)对产生的种群 X使用式(8)进行反向计算,得到反向种群 X (i = 1 ,2,…,n)。

i oi

(3)从种群 X和 X 组成的[X,X ,X,X ,…,X,X ]中,评估和选择最优的 n个个体,组

on

o2

n

oi

i

1

2

o1

成新的种群 X 。

new

3 求解约束优化问题的 M ε - OIDE算法

3.1 改进的 ε 约束处理法 从上述两种不同的 ε 约束处理法的基本原理,可以看出两者之间存在以下

4点区别与联系。

( 1)解的可行性定义不同。在迭代过程中,TS - ε 处理法认为约束违反只要在 ε水平内就是可行可

比较的;而 Z - ε 处理法仍将约束违反度等于 0的解才算可行解,在 ε ( ε >0)水平内只能是暂时可接受

的,且可接受的定义只有在与另一个可行解比较时才有意义。

( 2)约束放松处理对象不同。Z - ε 处理法在 TS - ε 处理法对总约束违反度进行放松的基础上,对等

式约束设置了放松 δ 水平,保证了 Z - ε处理法在处理不等式约束占主导地位时对等式约束处理的优

越性。

( 3)初始放松水平的定义不同。TS - ε 处理法的初始放松程度的定义来源于初始种群某个约束违反

适中的个体,能较好地保证初始放松不过大或过小,避免算法陷入不可行域或早熟收敛;Z - ε处理法

对初始放松度 ε (0)和 δ (0)的定义需要人为选定,文献[10]中 ε (0)和 δ (0)则通常定义为 1,并给出了

选参的建议。

( 4)比较法则之间的联系。Z - ε 处理法与 TS - ε 处理法差别在于:它对两个个体都在 ε ( ε >0)水平

内的比较是基于约束违反大小而不是目标值的大小,这样可能遗漏目标值较好的不可行解。

在分析以上的区别与联系后,以 TS - ε处理法为基础,将 Z - ε约束处理法对等式约束额外进行 δ

放松的操作补充进入 TS - ε 处理法的整体框架,同时设置一个控制 ε (0)和 δ (0)的参数来多样化处理约

束优化问题。本文提出的改进的 ε 约束处理法在 TS - ε 处理法步骤基础上,补充以下两点。

- 4

a) δ (0)的定义和 δ 更新公式,一般最终解允许等式约束违反存在 δ = 10 的放松:

0

— 1 5 —